近年来,随着体育赛事的线上化,尤其是世界杯、奥运会等全球性热点赛事的直播需求激增,直播平台面临的挑战愈发严峻。某次欧洲杯决赛期间,国内某头部体育直播平台因用户量瞬间突破500万,直接导致系统崩溃:弹幕卡顿、视频延迟、用户无法登录,甚至平台首页直接宕机。这场事故不仅让用户愤怒,更让平台损失了数百万的广告收入和用户信任。

类似的问题并非个例:

直播卡顿:带宽不足、CDN调度失效,导致用户观看体验极差;

弹幕崩溃:WebSocket连接数暴增,服务端无法处理海量消息;

数据库阻塞:用户评论、积分操作等高频写入导致数据库锁死;

单点故障:核心服务未做容灾,一处崩溃引发全盘瘫痪。

这些问题的本质,是传统架构无法应对高并发场景下的流量洪峰。那么,“东莞梦幻网络科技”是如何设计一个能够扛住百万级用户同时在线的体育直播系统?

高并发场景下的直播系统,其核心挑战可以归结为以下几点:

流量洪峰的不可预测性

体育赛事的直播流量具有极强的突发性,例如进球瞬间、红牌判罚等关键节点,用户量可能在10秒内暴涨10倍。传统架构缺乏弹性扩容能力,导致资源不足。

连接管理混乱

WebSocket长连接是直播弹幕的核心技术,但百万级连接需要高效的连接管理。如果每个连接都直接与后端服务交互,服务端压力会呈指数级增长。

数据写入瓶颈

弹幕、评论、用户操作等高频写入操作,如果直接写入数据库,会导致锁表、阻塞甚至崩溃。

单点故障风险

传统架构中,推流、拉流、数据库等核心组件往往是单点部署,一旦出现故障,整个系统将不可用。

成本与体验的平衡

高并发需要大量服务器资源,但过度配置会导致成本飙升。如何在保证用户体验的同时优化成本,是架构设计的核心难题。

基于上述痛点,东莞梦幻网络科技开发出了一套经过实战验证的高并发体育直播系统架构方案,其核心思路可以总结为以下八点:

前端接入层优化

多地域CDN分发:将视频流和静态资源(如JS、CSS、图片)部署到全球CDN节点,减少用户访问延迟。

OpenResty处理WebSocket:利用OpenResty的高并发能力处理百万级WebSocket连接,避免服务端压力过大。

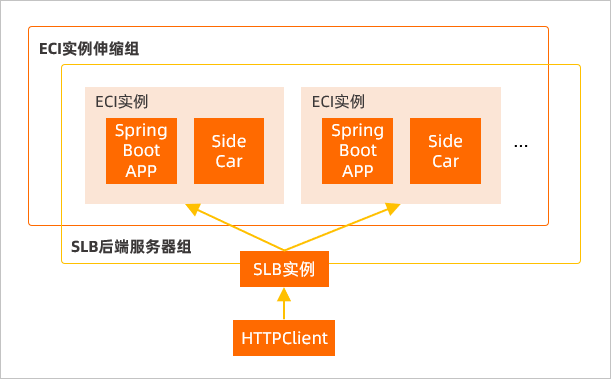

微服务拆分 + 服务网格

独立部署核心服务:将聊天、用户、积分、推流等功能拆分为独立微服务,避免单点故障。

gRPC + Nacos调度:使用gRPC实现服务间高效通信,Nacos实现服务注册与发现,提升系统稳定性。

弹幕/评论系统解耦

Kafka队列缓冲:弹幕消息先写入Kafka队列,异步消费后写入数据库,避免直接写库导致的阻塞。

Redis缓存热门内容:将高频访问的弹幕内容缓存到Redis,减少数据库压力。

WebSocket连接管理

Redis统一管理连接状态:通过Redis记录用户连接状态,避免服务端内存溢出。

心跳 + 超时踢人:定期检测连接活跃度,清理无效连接,释放资源。

Pub/Sub精准推送:利用Redis的Pub/Sub机制实现消息的精准推送,减少无效广播。

数据层优化

MySQL主从 + 分库分表:通过主从复制和分库分表提升数据库读写性能。

热数据进Redis:将高频访问的数据(如用户信息、赛事比分)缓存到Redis,异步写回数据库。

视频推流/拉流优化

多协议支持:推流支持RTMP、SRT、HLS等多种协议,适配不同场景。

CDN + 自适应多码率:拉流全交给CDN,并根据用户网络状况自适应调整码率,保证流畅播放。

服务降级 + 容灾切换

弹幕降级不影响直播:当弹幕服务崩溃时,自动降级为“只播不弹”模式,保证直播核心功能正常。

熔断 + 多机房部署:通过熔断机制隔离故障服务,多机房部署实现容灾切换,确保业务连续性。

实时监控 + 自动扩容

Prometheus + Grafana监控:实时监控系统指标(如CPU、内存、连接数),提前发现异常。

云厂商联动扩容:与阿里云、腾讯云等云厂商联动,根据流量自动扩容,确保资源充足。

高并发体育直播系统的架构设计,本质上是一场资源与流量的博弈。其核心逻辑可以总结为三点:

解耦与隔离:将核心功能拆分为独立服务,避免单点故障;

缓冲与异步:通过队列、缓存等技术缓冲流量洪峰,避免直接冲击数据库;

弹性与容灾:通过自动扩容、多机房部署等技术提升系统弹性,确保业务连续性。

正如东莞梦幻网络科技的体育直播源码方案所示,只有通过系统性优化,才能在百万级并发场景下扛住压力,为用户提供流畅的观看体验。对于开发者而言,掌握这套方法论,不仅能解决技术难题,更能为职业生涯增添一份硬核竞争力。

Copyright © 2013-2023 www.mhuan.vip. All Rights Reserved.粤ICP备19101276号